訂閱

訂閱

編者按:本文由Trust Insights公司授權轉載,該公司幫助營銷人員解決/實現收集數據和衡量數字營銷努力的問題。

點擊相應的鏈接進行閱讀第1部分,第2部分,第3部分這個係列的。

簡介

人們反複認為人工智能(AI)是一種神奇的東西,可以從無到有,這導致許多項目誤入歧途。這就是為什麼2019年普華永道首席執行官調查顯示,隻有不到一半的美國公司正在著手實施戰略人工智能計劃——失敗的風險很大。在本係列中,我們將研究AI項目在AI之旅開始時最常見的失敗方式。在你自己的人工智能計劃中,要注意這些失敗——以及補救或防止它們的方法。

第4部分:與建模相關的AI故障

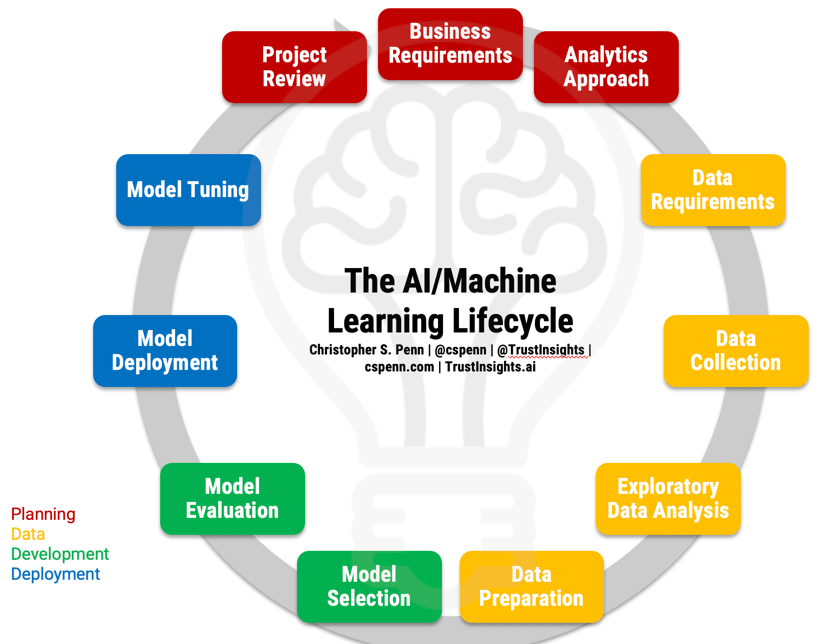

在我們討論失敗之前,讓我們回顧一下AI項目的生命周期,了解應該發生什麼。

獲取生命周期的整頁PDF從我們的即時洞察主題,並跟隨。

現在我們已經確定了總體策略中的主要問題,讓我們將目光轉向我們在生命周期的建模部分中可能遇到的主要問題:

- 模型選擇

- 模型評價

模型選擇

在機器學習和人工智能中選擇一個模型圍繞著兩個關鍵決策:

- 我們在處理什麼樣的數據?

- 這種數據的模型是什麼,能夠在相互競爭的目標之間提供最佳的平衡?

許多新手機器學習公司和從業者犯的一個關鍵錯誤是隻選擇他們知道的模型,或者僅僅根據一個標準——已知模型性能來選擇模型。你會經常讀到贏得重大比賽的特定模型和技術;例如,XGBoost多年來一直是Kaggle比賽的寵兒。解決辦法不是從流行什麼開始,而是從你有什麼樣的數據開始。

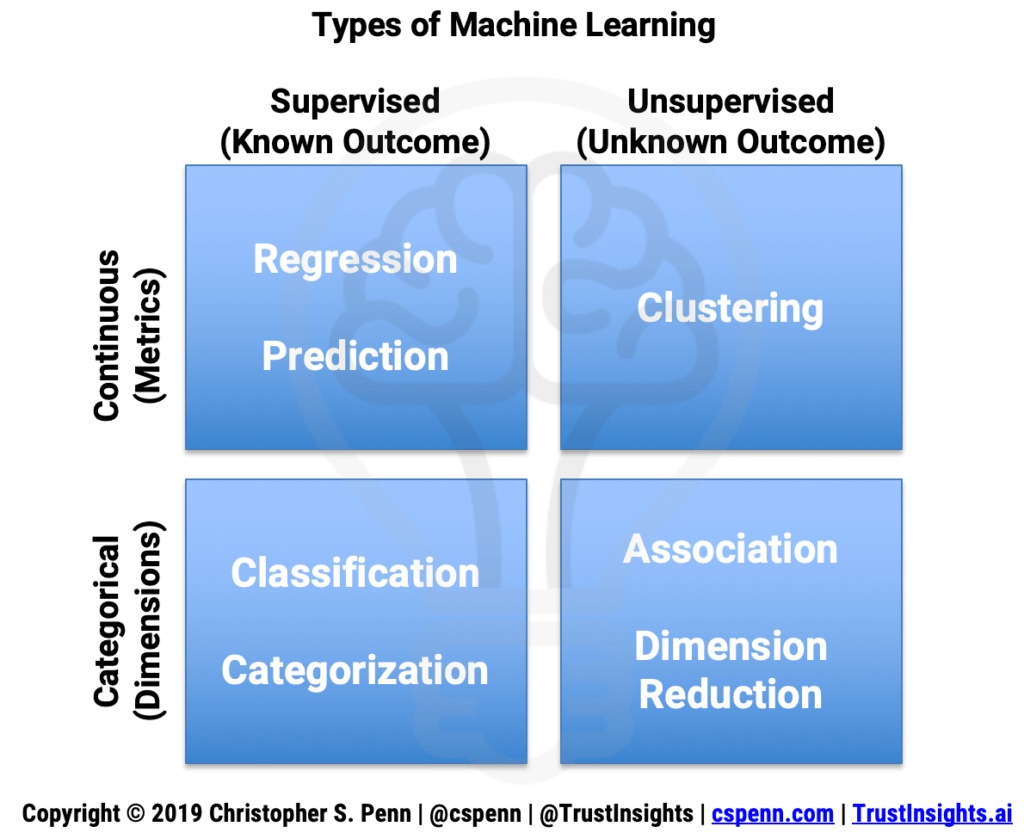

考慮機器學習問題矩陣:

我們麵臨四種不同的問題:

- 監督連續-我們知道我們要得到什麼結果,數據是數值的

- 無監督連續——我們不知道我們追求的是什麼結果,而且數據是數值的

- 有監督的分類——我們知道我們追求的是什麼結果,而且數據是非數值的

- 無監督分類——我們不知道我們追求的是什麼結果,而且數據是非數值的

我們可以用這些來解決什麼樣的營銷問題呢?

- 有監督的連續-什麼渠道驅動我們網站的轉換?

- 無監督連續——我們應該注意哪些SEO數據點?

- 監督分類——這一堆Instagram帖子的情緒是什麼?

- 無監督分類-在這一係列文章中最常見的主題是什麼?

在這些類別中,我們有一個技術庫:

- 監督連續

- 回歸:序數,泊鬆,隨機森林,增強樹,線性,深度學習

- 無人監督的連續

- 聚類:k均值,協方差,深度學習

- 監督分類

- 分類:決策樹,邏輯回歸,神經網絡,KNN,樸素貝葉斯,深度學習

- 非監督分類

- 降維:PCA, LDA, CCA, TSNE,深度學習

每種技術都有優缺點,這就導致了第二個主要問題和失敗點:僅根據性能選擇模型。生產機器學習的現實是,我們不僅要平衡模型的性能,還要平衡計算成本。一些機器學習算法提供了一流的模型性能,但對計算的要求很高,使得它們不適合在生產中使用,特別是在實時環境中。

例如,你是否注意到情緒分析,尤其是在社交媒體監控工具中,一直都很糟糕?這並不是因為情緒分析軟件不好。這是因為對於軟件即服務(SaaS)公司來說,一些最好的情感分析技術的計算成本太高了。當我們點擊或點擊設備上的一個按鈕時,我們已經開始期待即時的結果,而情緒分析做得好絕不是即時的。因此,SaaS公司仍然依賴老式的、效率較低的情緒分析模型,這些模型提供的結果很差,但從用戶的角度來看是即時的。

你的公司在機器學習項目中需要達到怎樣的平衡?答案取決於成本——你願意購買多少計算機?最終,機器學習和人工智能應該會帶來更高的成本效益,所以一定要選擇那些能以更低成本帶來更好結果的模型。

這導致了模型選擇上的最後一個錯誤:環境變化得如此之快,如果您和您的團隊沒有跟上潮流,您可能會錯過大量的成本節約和改進的結果。回到情感分析的例子,在自然語言處理(NLP)的世界中,最古老的NLP風格使用原始的方法,如單詞袋,這是當今生產工具中大多數情感分析使用的方法。2016年,向量化接管了性能的桂冠,像Facebook的FastText這樣的庫成為了性能的衛冕冠軍,同時沒有大幅增加計算成本。2018年,BERT、ELMO、Grover和GPT-2等預訓練模型從向量化中獲得桂冠,目前NLP中的黃金標準是GPT-2和XLNet使用的預訓練/微調方法。如果你沒有跟上最新的進步,你可能會錯過大量提高你的質量和效率的機會。

模型評價

一旦我們選擇了一個模型,我們就需要評估它的性能。在模型評價中存在兩種主要錯誤:測度選擇錯誤和過擬合。

不正確的度量選擇非常直接:您使用了錯誤的度量來評估模型的性能。這種情況最常發生在機器學習新手工程師身上,他們錯誤地分類了一個問題,或者他們的背景中沒有任何統計培訓。許多從軟件和編碼背景中找到機器學習方法的人缺乏統計計算方麵的正式培訓。比如,MSE和R^2哪個更好?答案取決於我們要解決的回歸問題的類型。MSE可以很好地檢測不尋常的、意外的值。R^2是無標度的,這有助於我們調優和比較模型。

對不正確的測量選擇的解藥是正規的統計培訓,公司和個人可以通過在線課程輕鬆獲得這些培訓。

第二個主要問題是過擬合。這也是非常直接的:很容易做出一個在曆史數據上表現完美的機器學習模型。畢竟,事後諸葛亮是明智的。困難在於預測未來,至少在涉及監督學習問題時是這樣。過度擬合模型可以完美地預測過去,但在接收到的新數據上表現糟糕。這是因為過去不是未來——我們需要建立能夠適應未來不確定性的模型。

過度擬合的解藥與過程有關;在我們的模型評估階段,僅僅查看模型性能是不夠的。我們應該將我們的訓練數據集分成至少2個(如果不是3個或更多)分區。一般的最佳實踐是將數據分成60% / 20% / 20%的部分。我們在前60%的訓練數據上訓練我們的模型。然後我們使用接下來的20%作為我們的測試數據,模擬進入模型的新數據,包括潛在的新異常。這80%的數據創建了我們最終的生產模型。然後,我們使用最後的20%作為驗證數據,在模擬生產環境中證明或否定最終模型(無需對其進行更多訓練)。如果該模型能很好地處理所有3個數據集,那麼它可能也能很好地處理未來的數據。

下一篇:建模會出什麼問題?

模型選擇和評估可以通過IBM所謂的“AI for AI”進一步改進,使用自動化流程來加速選擇和評估。AutoML和IBM Watson AutoAI等軟件可以以比人類機器學習工程師快得多的速度進行模型選擇,並同時評估數十個(如果不是數百個)模型的性能。

接下來,我們將關注生命周期的部署部分中最有可能出錯的地方。請繼續關注!

-1.png)

-1.png)

-1.png)